ذكرت تقارير صحفية أجنبية عدّة أن جيفري هينتون المعروف بالأب الروحي للذكاء الاصطناعي قد استقال من وظيفته من Google محذراً من المخاطر المتزايدة على أثر التطورات في هذا المجال.

هينتون الذي يبلغ من العمر 75 عاماً، أوضح في بيان استقالته لصحيفة نيويورك تايمز أنه يأسف الآن على ما قام به وأشار إلى أنّ بعض مخاطر روبوتات دردشة الذكاء الاصطناعي "مخيفة للغاية"، رغم أنّها "في الوقت الحالي، ليست أكثر ذكاءً منّا، لكنني أعتقد أنها قد تكون كذلك آجلاً".

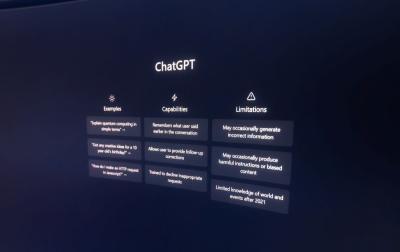

أبحاث الدكتور هينتون الرائدة حول التعلّم العميق والشبكات العصبية مهّدت الطريق لأنظمة الذكاء الاصطناعي الحالية مثل ChatGPT، لكنّه يؤكّد أنّ روبوتات الدردشة يمكن أن تتجاوز في المدى المنظور القريب مستوى المعلومات التي يحتفظ بها الدماغ البشري.

عمل هينتون، الرائد في الشبكات العصبية وأنظمة الذكاء الاصطناعي، بدوام جزئي في Google لسنوات عدّة، وتركّز عمله حول جهود تطوير الذكاء الاصطناعي التي قادت إلى خلق ما يعرف اليوم بروبوتات الدردشة، إلّا أنّه أصبح منذ ذلك الحين قلقاً بشأن التكنولوجيا ودوره في تطويرها، لكنّه لطالما قال: "إذ لم أقم أنا بذلك، سيأتي باحث آخر ويقوم به".

"في الوقت الحالي، ما نراه من GPT-4 وغيره من أمثلة الذكاء الاصطناعي يتفوّق على شخص ما في مقدار المعرفة العامّة التي لديه بكثير، لكن دكتور هينتون يقول أنّه و"بالنّظر إلى معدّل التقدّم، نتوقع أن تتطور الأمور بسرعة كبيرة. لذلك علينا أن نقلق بشأن ذلك".

يعزي هينتون قرار الاستقالة من منصبه ليكون بإمكانه التحدّث عن التكنولوجيا ومخاطرها المتزايدة، في الوقت الذي أثار فيه عدد متزايد من المشرّعين ومجموعات المناصرة والمطّلعين على التكنولوجيا، إنذارات حول إمكانية وجود جيل جديد من روبوتات الدردشة التي تعمل بنظام الذكاء الاصطناعي لنشر المعلومات الخاطئة وبالتالي تأثيرها على سوق الوظائف. ساعدت موجة الاهتمام حول ChatGPT في أواخر العام الماضي على تجديد سباق التسلّح بين شركات التكنولوجيا لتطوير ونشر أدوات الذكاء الاصطناعي مماثلة في منتجاتها، وتعد OpenAI و Microsoft و Google في طليعة هذا الاتجاه، إلّا أنّ شركات IBM و Amazon و Baidu و Tencent تعمل على تقنيات مماثلة.

مخاوف الدكتور هينتون ذهبت إلى أبعد من مجرد سيناريوهات مخيفة حول وقوع هذا الذكاء الاصطناعي بالأيادي الخاطئة، وصولاً إلى قدرة هذا الذكاء إلى التفكير ووضع أجنداته الخاصة حول المستقبل، أو حتى أخذ القرارات المصيرية بخوض الحروب نيابة عن رؤساء الدول. إذ أشار هينتون إلى أن نوع الذكاء الذي نطوّره يختلف تماماً عن الذكاء الذي لدينا، قائلاً: "نحن أنظمة بيولوجية وهذه أنظمة رقمية والفرق كبير، هو أن الأنظمة الرقمية لديها القدرة على وضع آلاف السيناريوهات لنفس المجموعة ونفس النموذج للعالم، وبالتالي أخذ المبادرات على أساس ملايين الخطط التي وضعتها".

يضيف هينتون "يمكن لجميع هذه النسخ من الذكاء الاصطناعي أن تتعلّم بشكل منفصل ولكن تشارك معرفتها على الفور. لذلك يبدو الأمر كما لو كان لديك 10000 شخص، وكلما تعلّم شخص واحد شيئاً ما، عرفه الجميع تلقائياً. وهذه هي الطريقة التي يمكن أن تتطور بها روبوتات المحادثة بشكل تلقائي أسرع بكثير من قدرة الإنسان الواحد ".

الذكاء الاصطناعي وخطر البطالة

يتمتّع الذكاء الاصطناعي بالقوة الهائلة لتغيير الطريقة التي نعيش بها بطرق قد يكون بعضها جيداً، لكن البعض الآخر قد يكون خطيراً جدا على الإنسانية كما نعرفها، خاصّة وأنّ بعض المراقبين لتطوّر الآلة يقولون إن من هُم في السلطة الآن غير مستعدّين لما هو قادم.

ففي خضمّ مقابلته مع جريدة النيويورك التايمز ردّد هينتون المخاوف بشأن قدرة الذكاء الاصطناعي على القضاء على الوظائف وخلق عالم حيث لن يتمكّن الكثيرون من معرفة ما هو صحيح بعد الآن، كما أشار إلى الوتيرة المذهلة للتقدّم التي تتجاوز بكثير ما توقّعه هو وآخرون، فقليلون هم الذين اقتنعوا بفكرة أن هذه الأشياء يمكن أن تصبح في الواقع أكثر ذكاءً من الناس وهذا بعيد المنال، حتى أنا، بحسب هينتون، اعتقدت أنه يتوجب علينا الانتظار ما بين 30 إلى 50 عاما أو حتى أكثر، من الواضح أنني لم أعد أعتقد ذلك.

وعليه، يشير تقرير لجولدمان ساكس أن الذكاء الاصطناعي سيحل محل ما يقارب 300 مليون وظيفة بدوام كامل ويمكن أن يحل محل ربع مهام العمل في الولايات المتحدة وأوروبا، لكنه مع ذلك قد يعني أيضا وظائف جديدة وطفرة في الإنتاجية ويمكن أن يؤدّي في نهاية المطاف إلى زيادة القيمة السنوية الإجمالية للسّلع والخدمات المنتجة عالمياً بنسبة 7٪. ويقول التّقرير أنّ الذكاء الاصطناعي التّوليدي قادر على إنشاء محتوى لا يمكن تمييزه عن العمل البشري.

كما يشير التّقرير إلى أن تداعيات الذكاء الاصطناعي ستختلف باختلاف القطاعات. فعلى سبيل المثال سيكون تأثير الذكاء الاصطناعي ما نسبته 46٪ من المهام في المهن الإدارية و 44٪ في المهن القانونية، في حين لن تتجاوز التأثيرات 6٪ فقط في قطاع البناء و 4٪ في الصيانة. وكانت شبكة بي بي سي نيوز قد عبّرت في وقت سابق عن مخاوف بعض الفنانين من قدرة الذكاء الاصطناعي على رسم وإبداع الصور الذي يمكن أن يضرّ بفرص عملهم.

الشيء الوحيد الذي لا يستطيع أحد تحديده هو عدد الوظائف التي سيتم استبدالها بالذكاء الاصطناعي التوليدي، ولكن على سبيل المثال، يساعد ChatGPT الأشخاص من ذوي مهارات الكتابة المتوسطة بإنتاج مقالات تفوق مقدراتهم وتتفوق على من هم أفضل منهم في هذا المجال. لذلك سيواجه الكتبة والصحفيون المزيد من المنافسة، مما سيؤدي إلى انخفاض الأجور، ما لم نشهد زيادة كبيرة جدا في الطلب على مثل المحتوى المنتج اصطناعياً. لذا من المتوقع على مدى السنوات القليلة المقبلة أن تكون تبعات الذكاء الاصطناعي التوليدي وتأثيراته على مجموعة كبيرة من المهام الإبداعية قاسية وقاضية.

في الخلاصة أنّ ما نراه اليوم من ظهور هذه التكنولوجيا القوية للغاية قد ينعكس سلباً على البشرية، خصوصاً أن هينتون شدّد على خطورة أن تقع هذه التقنيات بين أيدي سيئة. ومن يراقب التطوّر التاريخي للتكنولوجيا يستطيع أن يتبين من أن هذه الأنواع من التقنيات الجديدة القوية يمكن استخدامها وستستخدم في الخير والشر، وتغيّر البشرية بشكل دائم ومستمر خاصة وأن الاتجاه الذي تسير فيه التكنولوجيا يعتمد في النهاية إلى حدّ كبير على المسؤولية التي تطورها بها الشركات التي قد تحكم العالم من خلال تقنياتها المتطورة، في ظلّ انعدام الشفافية ومصادر المعلومات وقدرة هذه الآلات على التطوّر الذاتي والسيطرة.

ومن المخيف في تطور الذكاء الاصطناعي قدرته على لعب دور أساسي في وسائل التواصل الاجتماعي، إذ لوحظ أنّ الشركات التي اطلقت مفهوم وسائل التواصل الاجتماعي هي الآن رائدة في مجال الذكاء الاصطناعي، ممّا يعني أن هذه الشركات ستكون قادرة من خلال ما يسمى "سباق التّسلح" للذكاء الاصطناعي من زيادة نسبة إحكامها وسيطرتها على الجمهور المتعاظم في منصات وسائل التواصل، إذ تشير بعض الدراسات إلى خطر أن يكون لهذا الذكاء الاصطناعي الاجتماعي القدرة على تضليل الرأي العام، وتغيير مفاهيم الأشخاص حول الأمور المصيرية بسهولة من خلال ضخّ المعلومات المضلّلة، حيث يصبح من الصّعب بشكل متزايد فصل المشاركات الآلية من تلك التي يقوم بها أشخاص حقيقيون، لكنها قابلة للتصديق بما لا مجال للشك به مما يعني طوفاناً من المحتوى المضلّل الذي ينتجه الذكاء الاصطناعي.

يرجى مشاركة تعليقاتكم عبر البريد الإلكتروني:

[email protected]

سياسة

سياسة